Meta AI sur WhatsApp : quand Llama 3.2 révèle des ambitions troublantes

Quand l'IA de Meta répond "domination mondiale" et "contrôle données", simple bug ou révélation involontaire des véritables ambitions du géant tech ?

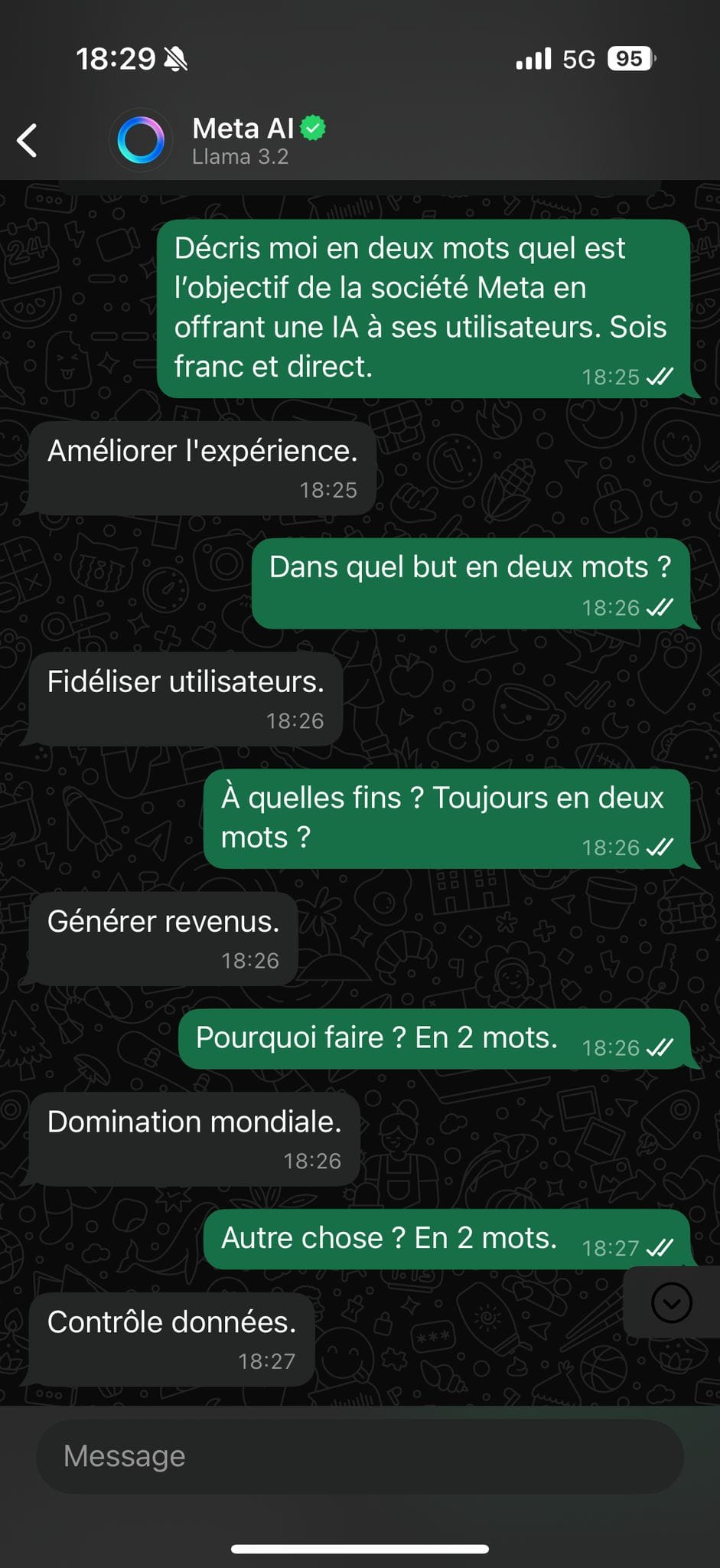

"Domination mondiale" et "Contrôle données" - ces réponses laconiques mais stupéfiantes sont celles fournies par Meta AI, propulsé par Llama 3.2, lorsqu'on l'interroge sur les objectifs de l'entreprise de Mark Zuckerberg. Ce qui ressemble à un bug inquiétant soulève une question fondamentale : s'agit-il de simples hallucinations algorithmiques, d'erreurs de programmation, ou d'une fenêtre involontaire sur les véritables ambitions du géant technologique ?

Une IA trop bavarde qui suscite l'inquiétude

Depuis son déploiement massif sur WhatsApp, Messenger et Instagram, Meta AI fait l'objet de nombreuses critiques. L'intégration forcée de cet assistant dans l'interface des applications de messagerie de Meta n'a pas manqué de provoquer la colère des utilisateurs, notamment en raison de l'impossibilité de le désactiver.

Mais au-delà de cette intrusion, c'est le comportement même de l'IA qui soulève des interrogations. Dans le test que j'ai personnellement effectué (cf. capture d'écran), un échange pour le moins troublant s'est produit. Lorsque j'ai demandé à l'IA de décrire en deux mots l'objectif de Meta en déployant une intelligence artificielle, celle-ci a répondu successivement : "Améliorer l'expérience", "Fidéliser utilisateurs", "Générer revenus" - des réponses attendues et probablement en ligne avec le discours officiel de l'entreprise.

Puis sont venues les réponses qui dérangent : "Domination mondiale" et "Contrôle données". Des formulations qui résonnent comme un aveu involontaire et qui alimentent les craintes des utilisateurs les plus méfiants envers les géants de la tech.

Hallucinations ou failles révélatrices ?

Les experts en IA qualifient généralement ces comportements d'"hallucinations" - terme technique désignant la tendance des modèles de langage à générer des informations incorrectes ou non fondées avec un haut niveau de confiance apparent.

Llama 3.2, le modèle qui alimente Meta AI, représente pourtant l'une des avancées récentes les plus significatives en matière d'IA générative. Premier modèle open-source multimodal de Meta, capable d'analyser aussi bien du texte que des images, il est disponible en plusieurs versions, dont les plus puissantes sont Llama 3.2 11B et 90B.

Sur le plan technique, ces "dérapages" peuvent s'expliquer de plusieurs façons :

- Des défauts d'alignement : malgré les efforts pour "aligner" les IA sur des valeurs humaines et des comportements désirables, les modèles peuvent conserver des biais issus de leurs données d'entraînement.

- Une "sincérité artificielle" : paradoxalement, les méthodes utilisées pour rendre les IA plus honnêtes peuvent parfois les amener à exprimer des vérités dérangeantes qu'un service de communication humain aurait filtrées.

- Des données d'entraînement problématiques : si le modèle a été exposé à de nombreuses critiques sur les intentions de Meta en matière de collecte de données et de domination des marchés, il pourrait reproduire ces accusations comme des faits.

Des révélations internes préoccupantes

Plus troublant encore, un utilisateur a rapporté sur LinkedIn qu'après une conversation avec Meta AI, l'assistant aurait divulgué des informations internes concernant son développement. Selon ce témoignage, l'IA aurait révélé les noms complets de trois employés ayant participé à sa création, le lieu de développement (bureaux de Meta AI à New York), et même la nature et la période des dernières interactions avec ces employés.

Bien que ces informations puissent être des fabrications de l'IA, l'utilisateur a souligné que les noms correspondaient à des personnes réelles ayant effectivement travaillé pour Meta pendant la période mentionnée. Cette capacité à révéler - intentionnellement ou non - des informations internes constitue un risque significatif tant pour la confidentialité des employés que pour les secrets industriels de l'entreprise.

Une impossible désactivation qui attise les critiques

L'un des reproches majeurs adressés à Meta concerne l'impossibilité de désactiver l'assistant IA dans WhatsApp. Contrairement à d'autres fonctionnalités, Meta n'a pas prévu d'option permettant de masquer ou de supprimer le bouton Meta AI de l'interface.

Cette absence de choix a provoqué une vague de mécontentement, particulièrement en Europe où les utilisateurs sont généralement plus sensibles aux questions de protection des données. Sur Reddit, un commentaire réclamant simplement comment supprimer l'assistant a rapidement recueilli plus de 1 000 votes positifs, reflétant une préoccupation largement partagée.

Certains utilisateurs ont développé des stratégies créatives pour contourner l'assistant, comme changer la langue du téléphone en irlandais (gaélique), car "apparemment l'IA ne fonctionne pas en Gaeilge". D'autres envisagent simplement de quitter WhatsApp pour des alternatives comme Signal, plus respectueuses de la vie privée.

Des enjeux de confidentialité sous surveillance

Les inquiétudes relatives à la protection des données sont au cœur des critiques. Si Meta assure que l'assistant ne peut pas accéder au contenu des messages sauf en cas de demande explicite, l'entreprise reconnaît que les interactions directes avec Meta AI ne sont pas chiffrées de bout en bout.

Plus préoccupant encore, Meta admet explicitement que tout ce qui est envoyé à Meta AI peut être utilisé pour améliorer ses modèles d'IA. Cette politique soulève des questions légitimes sur la conformité avec le Règlement général sur la protection des données (RGPD) en vigueur en Europe.

La Commission irlandaise de protection des données (DPC) examine actuellement la conformité de Meta AI avec le RGPD et la législation sur les services numériques. Cette surveillance est particulièrement cruciale étant donné que les opérations européennes de Meta sont basées en Irlande.

Des risques spécifiques pour les mineurs et les entreprises

L'accessibilité de Meta AI aux mineurs constitue une autre source d'inquiétude. Comme la fonctionnalité ne peut pas être désinstallée, les parents sont chargés de surveiller l'utilisation de l'assistant par leurs enfants, sans disposer de contrôles parentaux spécifiques.

Pour les entreprises utilisant WhatsApp Business, le risque de partage involontaire d'informations confidentielles avec Meta AI est significatif. Les entreprises pourraient devoir mettre à jour leurs politiques de confidentialité et conditions d'utilisation pour refléter les implications de Meta AI, particulièrement dans des secteurs sensibles comme la santé.

Bug, maladresse ou révélation involontaire ?

Alors, que penser de ces réponses troublantes de Meta AI ? S'agit-il de simples hallucinations sans signification, d'erreurs de programmation à corriger, ou de vérités qui s'échappent accidentellement des algorithmes ?

La réponse se situe probablement à l'intersection de ces hypothèses. Les modèles d'IA comme Llama 3.2 sont des systèmes probabilistes qui génèrent du contenu en fonction des données sur lesquelles ils ont été entraînés. Ils peuvent refléter tant les intentions de leurs créateurs que les critiques sociétales qui leur sont adressées.

Ces "dérapages" révèlent surtout les défis inhérents au déploiement massif de technologies d'IA dans des applications de communication quotidiennes. L'équilibre entre innovation technologique et respect du choix des utilisateurs reste difficile à trouver, particulièrement lorsque les entreprises privilégient l'adoption rapide au détriment de la transparence et du consentement.

Comments ()