Apple Silicon révolutionne l'IA : votre Mac devient une centrale d'intelligence indépendante

L'intelligence artificielle s'émancipe du cloud

Les MacBook équipés de puces Apple Silicon (M1, M2, M3, M4) ne sont plus seulement des ordinateurs portables élégants et performants. Ils sont devenus de véritables centrales d'intelligence artificielle capables d'exécuter localement des modèles sophistiqués qui, jusqu'à récemment, nécessitaient des serveurs distants. Cette transformation profonde change la donne pour les professionnels et les utilisateurs soucieux de leur vie privée.

L'architecture révolutionnaire d'Apple Silicon, intégrant CPU, GPU et Neural Engine au sein d'un même système sur puce (SoC), s'avère particulièrement adaptée à l'exécution de grands modèles de langage (LLM). La mémoire unifiée de ces puces élimine les transferts coûteux de données entre différentes mémoires dédiées, accélérant considérablement le traitement des modèles IA.

MLX : le framework discret qui change tout

Sans grande fanfare médiatique, Apple a publié MLX, un framework open-source spécifiquement conçu pour optimiser le fonctionnement des modèles d'IA sur ses puces maison. Cette annonce, faite discrètement via les réseaux sociaux plutôt que lors d'une conférence majeure, témoigne d'une stratégie d'Apple différente de ses présentations produits habituelles.

MLX permet aux développeurs de créer et d'exécuter efficacement des modèles d'apprentissage profond directement sur les Mac. Sa conception exploite toutes les spécificités architecturales des puces Apple, notamment l'intégration CPU-GPU-Neural Engine et la mémoire unifiée.

Private LLM : l'assistant IA qui respecte votre vie privée

À l'heure où la confidentialité des données devient une préoccupation centrale, Private LLM se positionne comme une alternative séduisante aux services d'IA cloud. Cette application payante (sans abonnement) permet d'interagir avec différents modèles de langage directement sur son Mac, sans transmettre aucune donnée à des serveurs externes.

Private LLM prend en charge une impressionnante collection de modèles récents :

- Llama 3.2 et 3.1 (Meta)

- Google Gemma 2

- Microsoft Phi-3

- Mistral 7B

- StableLM 3B

Sa technique de quantification avancée, baptisée OmniQuant, préserve mieux la distribution des poids des modèles comparée aux méthodes traditionnelles, offrant ainsi des réponses plus précises et plus rapides.

L'intégration avec Siri et les Raccourcis Apple permet de créer facilement des workflows IA sans programmer. Pour les utilisateurs macOS, l'application propose également des services linguistiques IA (correction grammaticale, synthèse, etc.) accessibles depuis diverses applications du système.

LM Studio : la solution polyvalente pour expérimenter

Développé par un ancien ingénieur d'Apple, LM Studio s'impose comme l'une des solutions les plus accessibles pour explorer les LLM en local. Son interface inspirée de ChatGPT simplifie l'utilisation de modèles téléchargés depuis Hugging Face.

LM Studio supporte principalement les modèles au format GGUF et MLX (ce dernier exclusivement sur Mac). Pour une expérience fluide, un minimum de 16 Go de RAM est recommandé sur les Mac Apple Silicon – une configuration désormais standard sur la plupart des modèles récents.

Les dernières mises à jour ont enrichi LM Studio de fonctionnalités professionnelles comme le RAG (Retrieval-Augmented Generation) et une API locale, permettant son intégration dans des workflows plus complexes.

NotesOllama : l'IA générative directement dans Notes

Pour les utilisateurs qui souhaitent principalement améliorer leur productivité dans l'application Notes d'Apple, NotesOllama représente une solution élégante. Cet utilitaire basé sur Ollama ajoute un bouton dans l'interface de Notes pour accéder instantanément à l'IA.

NotesOllama propose neuf commandes préinstallées (résumer la sélection, expliquer, répondre, etc.) et permet d'en créer des personnalisées. Bien que l'intégration ne soit pas parfaite (l'utilitaire utilise le presse-papier pour insérer le texte généré), il offre un avant-goût intéressant de ce que pourrait être l'IA générative native dans l'écosystème Apple.

DeepSeek R1 : le modèle qui a séduit Tim Cook

DeepSeek R1, développé par la startup chinoise DeepSeek, incarne parfaitement la vision d'Apple en matière d'IA locale. Ce modèle nécessite significativement moins de ressources que ses concurrents tout en offrant des performances remarquables.

Le coût d'entraînement de DeepSeek R1 représente seulement 3 à 5% de celui de GPT-4o, et sa mémoire requise (4 Go) est vingt fois inférieure à celle des modèles cloud traditionnels. Ces caractéristiques en font un candidat idéal pour l'exécution sur des appareils Apple.

Tim Cook, PDG d'Apple, aurait d'ailleurs exprimé son admiration pour ce modèle, qui valide l'approche d'Apple privilégiant des modèles d'IA légers fonctionnant directement sur les appareils. Les récentes optimisations du framework MLX, notamment le support natif de la quantification 4-bit, semblent avoir été influencées par l'architecture de R1.

Ferret 7B : l'IA multimodale signée Apple

Apple ne se contente pas d'optimiser des modèles tiers. Avec Ferret 7B, développé en collaboration avec l'Université Cornell, la firme à la pomme propose son propre modèle multimodal capable d'interpréter et de créer des contenus combinant images et texte.

Contrairement à d'autres initiatives d'Apple, Ferret 7B est open-source, permettant à d'autres développeurs de l'utiliser et de l'améliorer. Le modèle excelle dans l'analyse d'images, pouvant examiner une région spécifique d'une image, identifier les éléments pertinents et répondre à des questions les concernant.

Pourquoi l'IA locale change la donne

L'adoption croissante de l'IA locale sur Apple Silicon s'explique par plusieurs avantages décisifs :

1. Confidentialité et sécurité

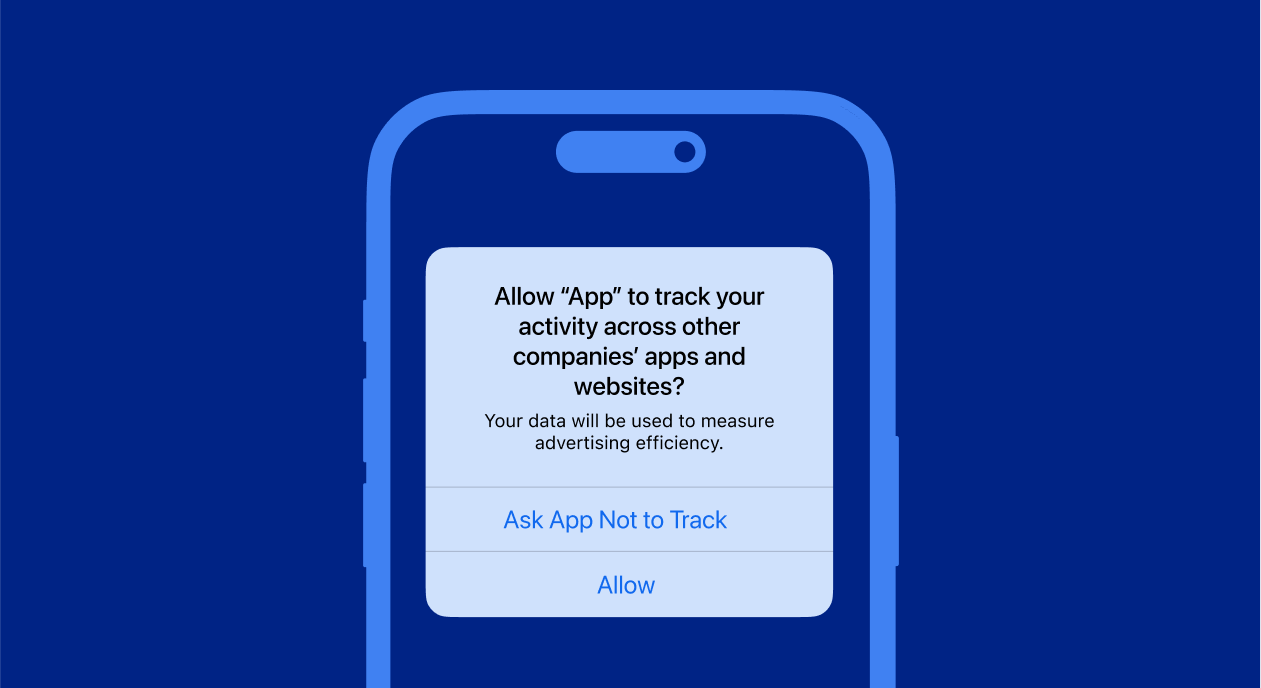

Contrairement aux services cloud qui peuvent collecter et analyser les données utilisateurs, les solutions locales garantissent que les informations restent sur l'appareil. Cette considération est cruciale pour les professionnels traitant des données sensibles.

2. Fonctionnement hors ligne

L'indépendance vis-à-vis d'une connexion internet représente un atout majeur pour les utilisateurs en déplacement ou travaillant dans des zones mal couvertes.

3. Absence de censure

Les modèles exécutés localement échappent aux restrictions potentiellement imposées aux services cloud, offrant une liberté précieuse aux chercheurs et journalistes.

4. Réactivité accrue

L'exécution locale élimine les délais réseau, permettant des interactions plus fluides et naturelles avec l'IA.

Un écosystème en pleine effervescence

L'écosystème de l'IA locale sur Apple Silicon gagne chaque jour en maturité, offrant des solutions accessibles tant aux utilisateurs non techniques qu'aux développeurs. Cette tendance s'aligne parfaitement avec la vision d'Apple d'une technologie puissante mais respectueuse de la vie privée.

La stratégie d'Apple consistant à développer des puces optimisées pour l'IA et des frameworks comme MLX porte ses fruits, positionnant l'entreprise comme un acteur incontournable de cette révolution. Avec l'arrivée d'Apple Intelligence et d'autres innovations, les utilisateurs de Mac peuvent s'attendre à des capacités d'IA locale toujours plus impressionnantes dans les années à venir.

L'ère où l'intelligence artificielle nécessitait obligatoirement une connexion à des serveurs distants touche à sa fin. Bienvenue dans l'âge de l'IA autonome, directement dans votre MacBook.

Comments ()